出品 | 本站

今天凌晨,Sam Altman 终于满意地回击了一把谷歌!

Google Gemini 3 发布后,AI 行业的风向明显变了——谷歌在推理测试里反超 OpenAI,让 Sam Altman 直接向内部发出“红色警戒”。

仓促发布 5.1 没几天,GPT-5.2 自带BGM来了!业界视为,该版本模型才是警戒后的第一次正面回应。

Sam 在X上自豪地表示:它是目前世界上最智能的通用模型,尤其擅长处理现实世界的知识工作任务!

图片

图片

OpenAI 发布全新旗舰模型 GPT-5.2,并以三种形态同时上线:Instant(速度型)、Thinking(推理型)、Pro(专业型)。

官方强调,5.2 能在电子表格、演示文稿、代码生成、长上下文分析、图像理解、多步骤规划等场景里明显提升可靠性和生产价值。

图片

图片

OpenAI 还宣布 GPT-5.2 向所有用户推送,其中 Instant 适合日常学习、Thinking 适合专业任务,而 Pro 则适合复杂问题。当然,还是先从付费计划开始,目前 API 已可用。

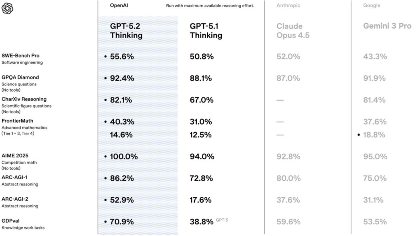

这次升级的核心,是推理。OpenAI 把 GPT-5.2 的 Thinking 模式定位为“通用深度推理引擎”,并明确拿 Gemini 3 Deep Think 做对比。测试结果显示:

在 OpenAI 的基准测试图表中,GPT-5.2 Thinking 在几乎所有列出的推理测试中都胜过 Gemini 3 和 Anthropic 的 Claude Opus 4.5,从现实世界的软件工程任务(SWE-Bench Pro)和博士级科学知识(GPQA Diamond)到抽象推理和模式发现(ARC-AGI)。

图片

图片

而这些能力提升的背后,实则是在为金融建模、预测分析、工程规划这些“真生产”场景铺路。

研究负责人 Aidan Clark 表示,数学成绩好不仅仅体现在解方程上。他解释说,数学推理能力可以衡量一个模型是否能够遵循多步骤逻辑,能否在一段时间内保持数值的一致性,以及能否避免那些可能随着时间推移而累积的细微错误。

Clark 指出:“这些特性在各种不同的工作负载中都非常重要,例如财务建模、预测和数据分析。”

OpenAI 在官网上表示,GPT-5.2 可生成更可靠、可量产的代码。

说法很克制,但开发者圈子里反响很炸裂。

官方还称,在决策、研究、写作等日常任务里,Thinking 模式的错误率已降低 38%。

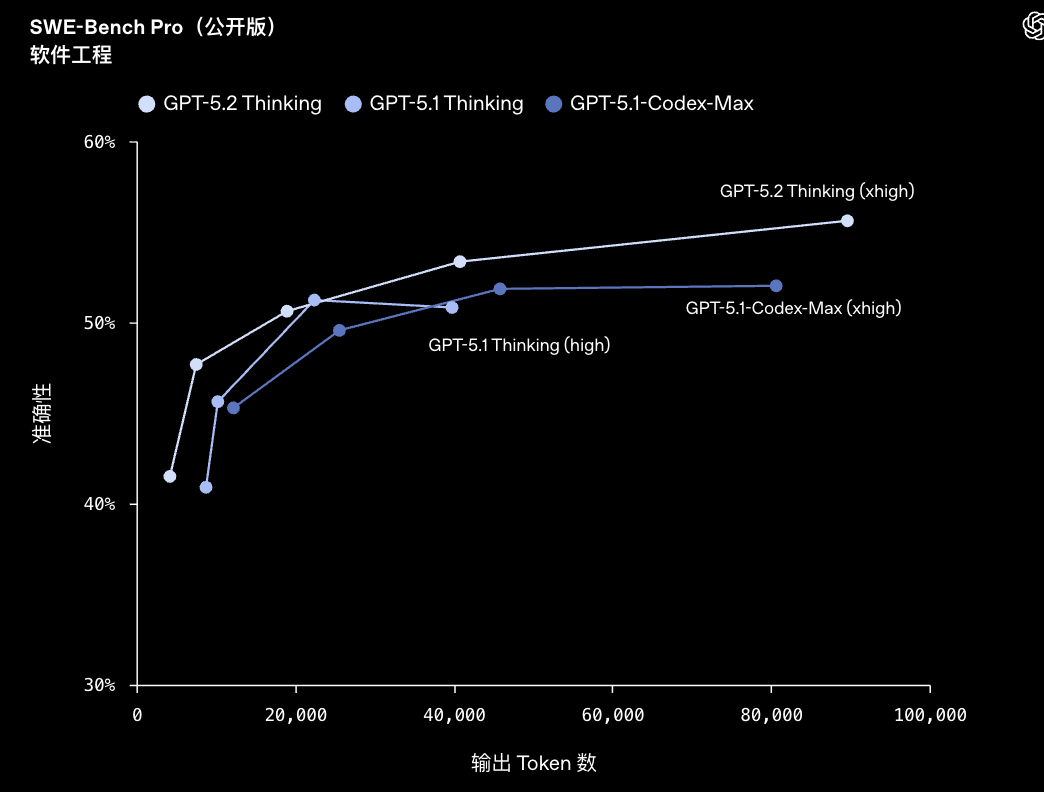

GPT‑5.2 Thinking 在 SWE-bench Pro 测试取得了 55.6% 的新成绩。SWE-bench Pro 是一项严格评估真实软件工程能力的基准测试。与只测试 Python 的 SWE-bench Verified 不同,SWE-bench Pro 涵盖四种语言,旨在更具抗污染性、更具挑战性、更具多样性,也更贴近真实工业场景。

图片

图片

更令人惊喜的是,在 SWEvbench Verified 测试中,GPT‑5.2 Thinking 取得了我们全新的最高成绩:80%。

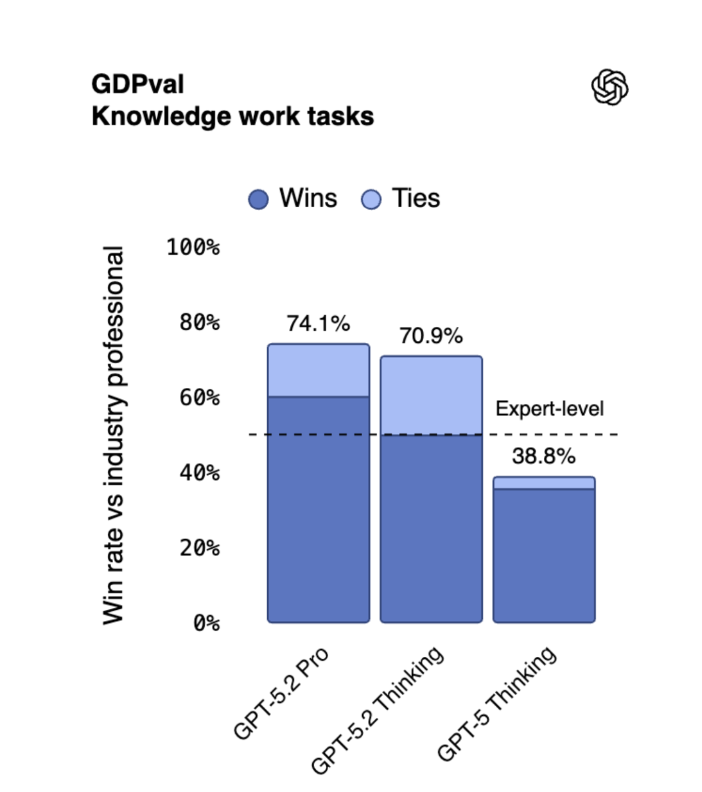

最最顶的是,Sam一直推崇的让大模型完成真实世界任务也有了新的大进展。

在 GDPval 评估中,GPT-5.2 Thinking 首次达人类专家水平(70.9%),显著提升长上下文推理、电子表格分析和演示创建,AIME 数学基准达 100%。

图片

图片

这意味着,在日常专业应用中,该模型能够更可靠地调试生产环境代码、实现功能需求、重构大型代码库,并以更少的人工干预完成端到端的修复交付。

GPT‑5.2 Thinking 在前端软件工程方面也优于 GPT‑5.1 Thinking。早期测试者发现,它在前端开发以及复杂或非传统的 UI 工作上表现更强(尤其是涉及 3D 元素的场景),这让它成为工程师在全栈工作中的强大日常伙伴。

下面是一个非常惊艳的使用实例。

提示:创建一个单页应用(单个 HTML 文件),展示一个温馨有趣的节日贺卡!该贺卡应具有交互性,可带给孩子们欢乐!

图片

图片

从 OpenAI 的 X 账号上可以看出,GPT5.2 专长于真实世界知识工作任务,如制作幻灯片、电子表格和代码,而这些能力已集成至 ChatGPT 和 API。

不过,早期用户反应有好有坏:开发者赞赏速度和代码能力提升,但部分人觉得日常使用变化小,响应过长且语气僵硬,适合研究而非 casual 交互。

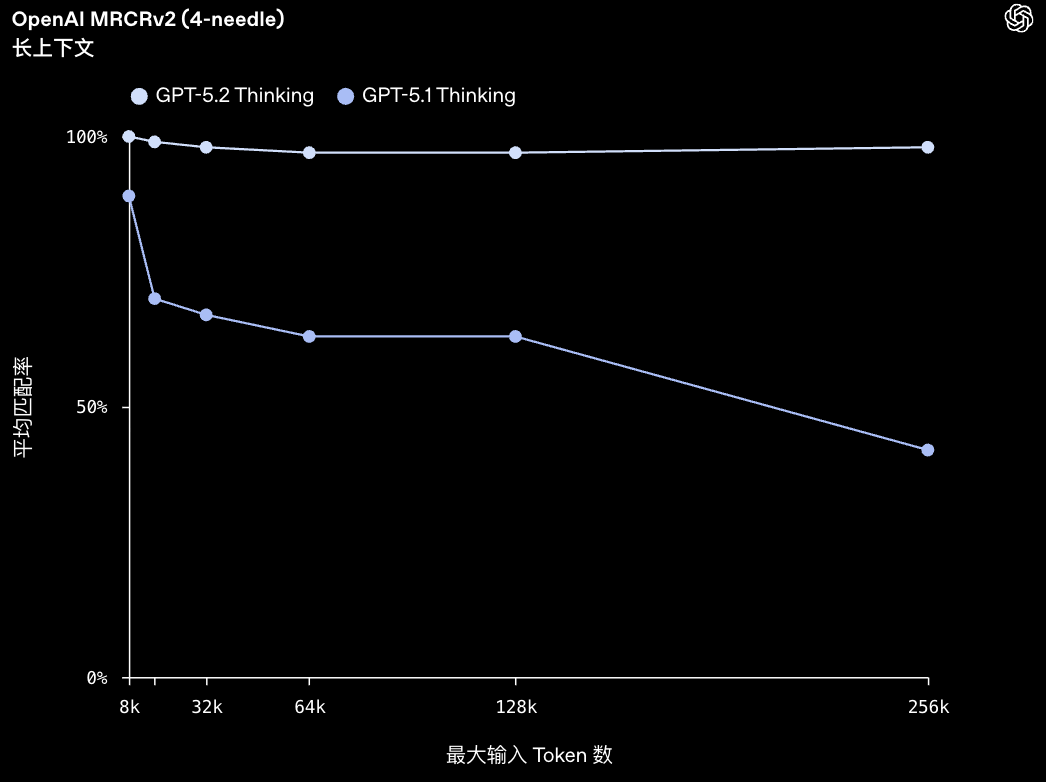

GPT‑5.2 Thinking 在长上下文推理方面树立了新的技术标杆。OpenAI MRCRv2 是一项用于测试模型整合长文档中分散信息能力的评估,GPT‑5.2 Thinking 在该评估中表现领先。

图片

图片

在真实任务中,例如深度文档分析(需要跨数十万 Token 关联信息),GPT‑5.2 Thinking 的准确性显著高于 GPT‑5.1 Thinking。

值得一提的是,OpenAI 首次看到:某个模型在 4-needle MRCR 评测变体(最长可达 256k Token)中实现接近 100% 的准确率。

图片

图片

在实际应用中,这让专业人士能够使用 GPT‑5.2 处理长文档,例如报告、合同、研究论文、会议记录和多文件项目,同时在数十万 Token 的范围内保持连贯性和准确性。因此,GPT‑5.2 尤其适合深度分析、信息综合以及复杂的多来源工作流程。

GPT-5.2 强点确实多,但成本也高得离谱。业内消息称,OpenAI 最近的推理算力大多已经不靠合作方积分,而是直接现金支付。

为什么?因为现在的推理模型成本已经高到“积分不够用”。

根据外媒报道,OpenAI 未来几年计划投入 1.4 万亿美元用于 AI 基建。这是一个会把对手吓出心理阴影的数字。

OpenAI产品负责人给的解释倒挺务实:“今天同样的钱能买到比一年前更强的智能水平”,寄望未来规模效应对冲成本。

当然,也有遗憾的地方。

外界原以为 OpenAI 会顺便带来一个“对标谷歌 Nano Banana Pro”的图像模型——毕竟谷歌最近的图像表现强到有点离谱,已经能自动生成高质量 PPT、逼真渲染和更懂世界知识,并已整合到谷歌Docs、AI 演示文稿等产品中。

但 OpenAI 这次没有在图像方面有新进展。业内消息称,下一代图像模型会在明年 1 月亮相,速度更快、风格更强、个性化能力更好。不过发布会上未得到确认。

此外,OpenAI 针对此前不少青少年方面的负面反馈也做出了回应,提出了一项新的安全方案:青少年验证与心理健康防护。OpenAI 同时公布:将为青少年用户引入年龄验证,以及一套心理健康使用的安全机制,不过这些更新未在发布会上详细说明。

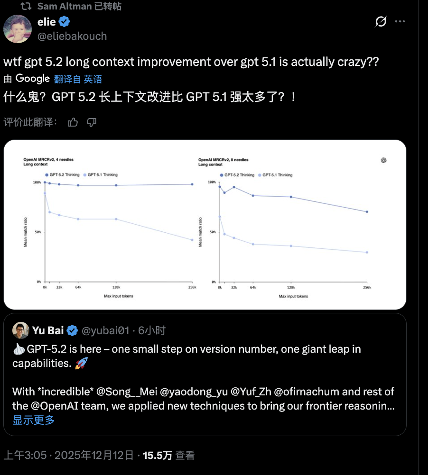

GPT 5.2刚上线,除了惊叹性能,在 Reddit 上,还引发了网友新一轮更深层的讨论:模型迭代速度、智能边界、价格曲线、是否逼近 AGI,以及“知识截止为什么仍然存在”。

其中网友讨论最热烈的是:迭代周期或已进入“四个月一更”时代。

不少用户注意到:如果训练数据截止在 2025 年 8 月,那预训练最早也要在 8 月之后才能结束;再加上微调、RLHF、红队测试,GPT-5.2 可能只用了 2~3 个月的后处理时间。

图片

图片

换句话说:如果这不是偶然,那么 OpenAI 或许已经形成了“四个月一重大更新”的节奏。

看来,模型更新已经越来越接近“软件更新”,而不再像是之前动辄长达半年甚至更久的“科研突破”。社区普遍认为:快速迭代会成为新常态。

对此,这种兴奋也给不少网友带来了担忧。“一年后回头看现在的模型,会觉得很糟!”

一位用户的评论代表了这种情绪:

“我们正在经历从第一代模型到接近 AGI 的‘蛮荒时代’,几年后回看会觉得这段时间像历史节点。”

但这样的快速迭代终究受益者是大家。有位网友认为:即便Scaling Law撞墙,智能增长进入“平台期”,成本也会继续暴跌。典型例子是:

所以社区预测:如果再降一个 300 倍,即便不更聪明,也足以改变整个劳动力结构。

多提一嘴,今年是OpenAI成立10周年,Sam 还特别发了一篇博文,他重申了OpenAI 对于通用智能的信仰。对于未来十年,他非常确定超级智能能够到来,而且,现在人类的日常生活和所最关心的事情都几乎不会变化。

我从未像现在这样对我们的研发和产品路线图,以及实现我们使命的整体方向感到如此乐观。我相信,再过十年,我们几乎肯定能够打造出超级智能。我预感未来会有些奇特;

在某种程度上,日常生活和我们最关心的事情几乎不会发生太大变化,而且我相信,我们会继续更加关注其他人所做的事情,而不是机器所做的事情。但在另一方面,2035年的人们将能够做到我们现在难以想象的事情。

好了,文章到这里结束了,评论区大佬如何看待未来大模型的发展呢?怎样看待GPT5.2的发布呢?

https://openai.com/zh-Hans-CN/index/introducing-gpt-5-2/

https://x.com/sama/status/1999184337460428962

我的官方站点图标